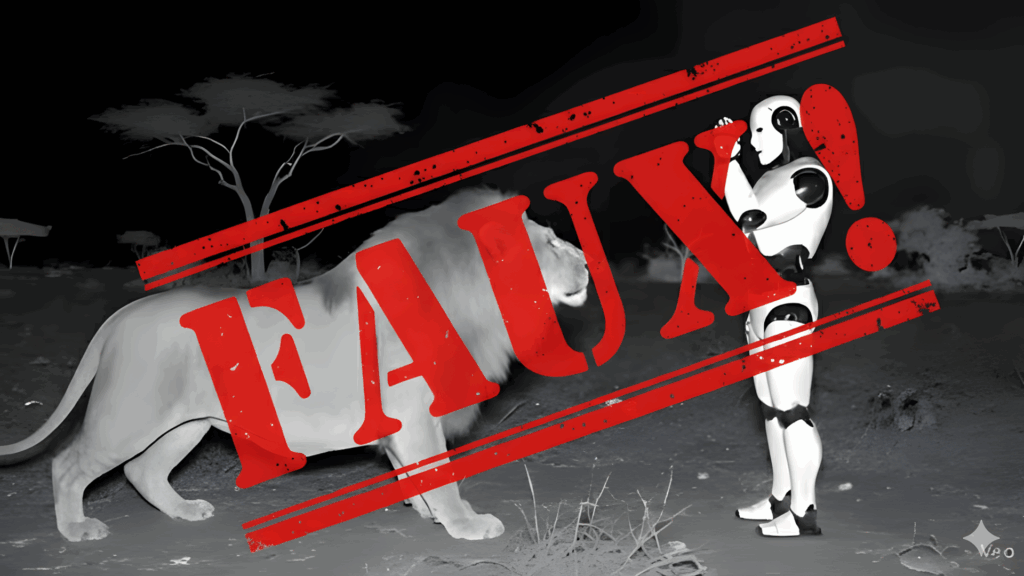

Interviewés par TF1 sur une vidéo montrant un robot terrorisé par un lion, nous avons démontré comment l’intelligence artificielle fabrique désormais ses propres mythes pour tromper des millions d’internautes.

Une publication affirme que des ingénieurs africains auraient investi 500 000 dollars pour confronter un robot à un lion. Selon cette histoire virale, la machine aurait ressenti de la peur et développé un stress post-traumatique. L’équipe aurait même dû retirer une partie de son processeur pour le soigner. Des millions de personnes ont partagé cette vidéo sur les réseaux sociaux.

TF1 nous a contactés comme experts en intelligence artificielle pour analyser cette intox. Notre conclusion est sans appel : Veo, l’IA de Google, a entièrement généré cette vidéo. Le logo apparaît clairement en bas à droite des images. Aucune trace d’une telle expérience scientifique n’existe dans la littérature académique ni dans les médias fiables.

L’origine de cette manipulation révèle une ironie troublante. Le blog source ne compte que trois publications, toutes créées par intelligence artificielle. L’IA a elle-même généré la photo de profil de l’auteur fictif. Les outils de détection confirment que le texte entier résulte d’une création automatisée. L’intelligence artificielle fabrique donc de fausses informations sur ses propres capacités.

Une machine ne ressent aucune émotion

Permettez-nous d’être directs sur ce point fondamental. Une IA n’est pas plus intelligente qu’un grille-pain. Elle effectue uniquement des calculs mathématiques et des opérations de probabilité. Quand elle semble comprendre, elle prédit simplement quelle réponse convient le mieux à une situation donnée.

Les émotions humaines impliquent des réactions physiologiques complexes que les machines ne possèdent pas. Votre cœur s’accélère face au danger, vous transpirez, vos mains tremblent. Une machine ne dispose ni de système nerveux, ni d’hormones, ni de conscience. Elle peut reconnaître des signaux expressifs et identifier les signes précurseurs d’une agression animale, mais elle ne ressent rien.

L’idée qu’un robot développe un syndrome de stress post-traumatique relève de la pure fiction. L’IA stocke des données et apprend de ses expériences passées. Néanmoins, ces informations peuvent être effacées instantanément, contrairement à la mémoire humaine qui constitue le fondement même de notre identité.

L’animisme numérique exploité par l’industrie

Cette croyance en des machines sensibles s’inscrit dans une tradition ancestrale. Nous projetons nos émotions sur ce qui nous entoure depuis toujours. Pensez au Golem de la tradition juive ou aux statues grecques animées par les dieux. Les robots n’échappent pas à cette tendance psychologique profondément ancrée.

Les constructeurs exploitent délibérément cette psychologie humaine. Ils conçoivent des robots avec des yeux expressifs et des comportements anthropomorphes. Un robot à l’apparence humaine est pris plus au sérieux qu’un bloc sur quatre roues. Cette stratégie facilite nos interactions avec les machines et sert leurs campagnes marketing.

Restons lucides face à ces artifices. Ces expressions faciales ne sont que des images affichées sur un écran. Nous humanisons ces machines parce qu’elles nous ressemblent, pas parce qu’elles éprouvent véritablement des sentiments. L’industrie utilise cette illusion pour nous séduire et vendre ses produits.

Une menace croissante pour l’information

La prolifération de ces fausses informations pose un problème majeur. Les outils génératifs deviennent si performants qu’ils créent des contenus presque indiscernables de la réalité. Le compte TikTok qui a diffusé cette vidéo ne partage que du contenu artificiel, conçu spécifiquement pour devenir viral.

Cette situation crée un cercle vicieux dangereux. L’IA génère du faux contenu sur l’IA elle-même, alimentant des croyances erronées sur ses capacités réelles. Les internautes partagent sans vérifier, les algorithmes amplifient, et la désinformation se propage à une vitesse fulgurante.

Face à cette vague de manipulation, le rôle des médias devient crucial. Les équipes de vérification investissent du temps et des ressources pour démêler le vrai du faux. Mais comment distinguer le réel de l’artificiel quand les machines fabriquent des mensonges toujours plus crédibles ?

Une précédente participation avec TF1 en juillet 2025

Des robots qui battent des humains au ping-pong ou au foot… vraiment ? Spoiler : non ! J’ai eu le plaisir de contribuer à une enquête diffusée samedi 20 juillet dans le journal de 20h de TF1 à propos des fausses vidéos de #robots qui circulent sur les réseaux sociaux.

Un sujet passionnant, car il mêle technologie, effets spéciaux, IA… et parfois manipulation. Le reportage explique pourquoi ces vidéos nous fascinent, comment reconnaître les trucages, et quels enjeux (commerciaux ou géopolitiques) se cachent derrière.

Sur le même sujet

LES ROBOTS HUMANOÏDES : LEURS ORIGINES ÉTONNNANTES RÉVÉLÉES – L’histoire des robots humanoïdes